This version (2024/10/24 10:28) is a draft.

Approvals: 0/1

Approvals: 0/1

VSC-3

- Installation Sommer 2014 durch ClusterVision

- 2020 Nodes

- 2x Intel Xeon E5-2650v2, 2.6 GHz, 8 Cores

- 64 GB Ram

- 2x Infiniband QDR (40 GBit/s)

- Ölgekühlt

- 39 Storage Server

- 9 Server für Home Filesysteme

- 8 Server für paralleles Global/Scratch Filesystem

- 16 Server für parallele Bioinformatik Filesysteme

- 2 Server für GPFS

- 4 Server für Testing

Parallele Dateisysteme am VSC-3

- Home Verzeichnisse

- NFS mounts via Infiniband QDR

- BeeGFS

- Geteiltes Filesystem für alle User

- Mehrere Targets/Server (GLOBAL, BINF)

- IBM GPFS

- Kooperation mit EODC (https://www.eodc.eu)

- Remote Cluster für EODC Filesysteme

BeeGFS (1/2)

- Erstellt vom Fraunhofer Center for High Performance Computing / ThinkparQ

- Ease of Use

- Performance

- Scalability

- Aufteilung Management / Metadaten / Daten

- Management Server

- Verbindung der Nodes

- Handling von Quotas

- Metadaten Server

- Speichern Metadaten

- Root Metadaten Server

- Metadaten Mirroring möglich

- Benötigen Filesystem (Typischerweise ext4)

- Idealerweise auf schnellen SSDs

BeeGFS (2/2)

- Storage Server

- Speichern Daten

- Mirroring möglich

- Benötigen Filesystem (Oftmals xfs)

- Monitoring

- BeeGFS-Admon daemon

- Command-Line tool

- Graphisches tool (Java)

Setup am VSC-3 (1/2)

- 8x Storage Server für Global/Scratch Filesystem

- Intel Xeon E5-1620 v2, 4 Cores / 8 Threads, 3.70 GHz

- 128 GB Ram

- 48x Toshiba 2 TB SAS Disks (MG03SCA200)

- Arrangiert in vier Raid6 Arrays zu je 12 Disks

- LSI SAS2208 Controller

- 2x Samsung 240 GB SSDs (MZ7WD240)

- Raid 1 (Linux Software Raid)

- 2x Infiniband QDR Controller (40 GBit/s)

- RDMA

- Provisionierung der Betriebssysteme In-Memory

- Mittels Bright Cluster Manager

- CentOS 7.4

- Projekt-Quotas

- 384 Disks

- ~0.5 PiB Space

- ~20 GiB/s Durchsatz

VSC - Fileserver

Setup am VSC-3 (2/2)

- 16x Storage Server für Bioinformatik Filesystem

- Computing auf den Knoten möglich

- 2x Intel Xeon E5-2690 v4, 14 Cores / 28 Threads, 2.60GHz

- 0.5TB - 1.5TB Ram

- 12x Seagate 8 TB SAS Disks (ST8000NM0075)

- 1 Raid6 Array an LSI SAS-3 3108 Controller

- 4x Intel DC P3600 SSDs

- 1 Raid10 (Linux Software Raid)

- 1x Infiniband QDR Controller (40 GBit/s)

- 1x Intel Omnipath Controller (100 GBit/s)

- RDMA

- Provisionierung der Betriebssysteme In-Memory

- Mittels Bright Cluster Manager

- CentOS 7.2

- Projekt-Quotas

- 192 Disks

- 64 SSDs

- ~1.1 PiB Space (100 TiB auf SSDs)

- ~80 GiB/s Durchsatz

VSC3 - Bioinformatics

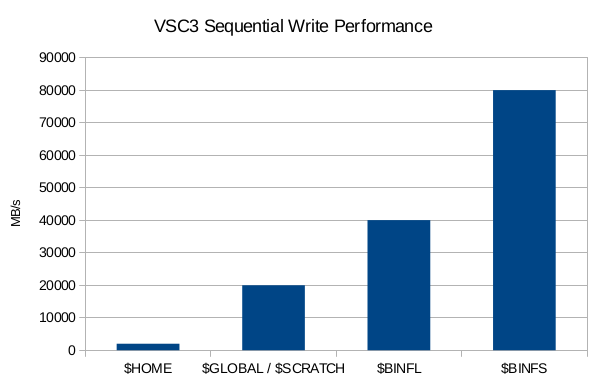

Storage Performance

Erfahrungen

- Bugs?

- Ja, speziell bei neuen Features

- Support?

- Exzellent

- Bedienung?

- Relativ einfach mittels beegfs-ctl und Installations-Skripts

- Läuft problemlos auf provisionierten in-memory images

- Tipps?

- Metadaten Targets groß genug wählen

- Beim Einsatz neuer Features diese zuerst Testen ;)

- Kein automatisches rebalancing beim Hinzufügen neuer Targets (manuell möglich)

- Viel Ram

- Kein Random I/O

IBM GPFS

- General Purpose Filesystem

- Früher Multimedia Filesystem

- Linux Support seit 1999

- Storage Pools

- Cluster Export Services

- Hadoop

- Features

- Striping

- n-way Replication

- Raid (Spectrum Scale Raid)

- Fast Rebuild

- In vielen TOP500 Systemen im Einsatz

- SuperMUC / München

- Juron, Julia / Jülich

- …

GPFS @ EODC

- EODC - Earth Observation Data Center for Water Resources Monitoring

- Processing Large Volumes of EO Data

- Sentinel Satellitendaten

- Viele Petabytes

- IBM ESS (Elastic Storage Server)

- Building Blocks

- Skalierbar

- 2xESS

- 4 Server

- TS4500 Tape Library

- TSM

- Muti-Tiered (IBM HSM)

- Dateien mit ältestem zugriffsdatum kommen auf Tape

- Bei Zugriff auf Stub File wird die Datei wieder vcon Tape auf Disk geholt

- Schedules, Callbacks, Migration Control, etc…

GPFS Server @ VSC-3

- Verbindung mittels Infiniband QDR

- 2 Management Server für Remote Cluster

- Tie-Breaker Disk an dritter Maschine für Quorum

- Keine Filesysteme / Keine Disks (nur Remote FS von EODC)

- GPFS 4.2.0

- 12 Infiniband QDR Links

- 500 Client Lizenzen

- ~40GiB/s Durchsatz

Erfahrungen

- IBM typisch manchmal archaische Programme

- Aber an sich Ok

- Integration in bestehende Systeme

- mmdsh als integrierte verteilte shell

- Nettes GUI / Monitoring

Ende

- Danke für die Aufmerksamkeit